안녕하세요. 빅데이터&AI사업부의 김강산입니다.

최근 구글 글래스(Google Glass)의 재조명이나 메타 퀘스트(Meta Quest) 같은 디바이스의 발전으로 AI가 세상을 바라보는 시각이 변화하고 있습니다. 과거의 AI가 CCTV처럼 고정된 위치에서 세상을 관찰했다면, 이제는 사람의 1인칭 시점(First-Person View)에서 의도를 이해하고 반응하는 기술이 핵심이 되고 있습니다.

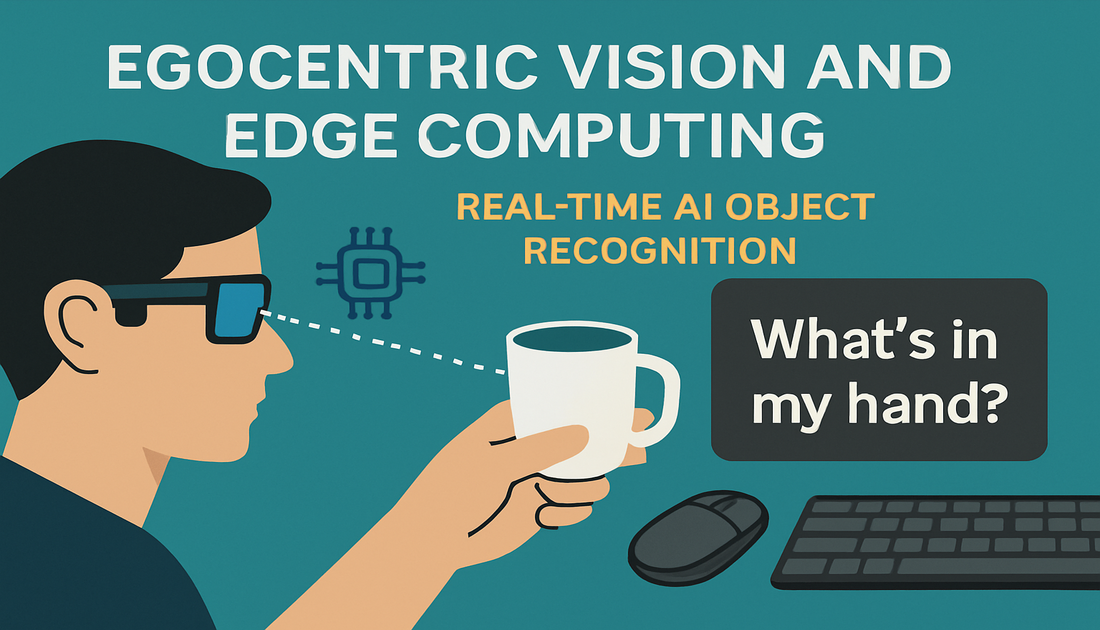

오늘 포스팅에서는 이 에고센트릭 비전(Egocentric Vision) 기술과 이를 실시간으로 처리하기 위한 엣지 컴퓨팅(Edge Computing)을 결합하여, 제가 직접 구현한 “What’s in my hand?” 프로젝트의 기술적 배경과 구현 과정을 상세히 소개하려 합니다.

1. 에고센트릭 비전: AI가 내 눈이 되다

1). 정의 및 핵심 분류

에고센트릭 비전(Egocentric Vision)이란, 사용자의 1인칭 시점에 보이는 시야를 입력으로 받아 주변의 객체, 손동작, 공간 맥락을 AI가 실시간으로 이해하는 기술입니다.

핵심은 한 문장으로 요약됩니다.

“내가 보는 것을, AI도 즉시 이해한다.”

이 기술은 단순히 화면을 녹화하는 것이 아니라, 아래 4가지 영역을 중심으로 지능형 인식을 수행합니다.

- 주체 이해 (Subject Understanding)

사용자의 손, 시선, 자세(Pose) 등의 정보를 파악하여 행동 의도를 이해합니다.

→ 이번 데모에서는 MediaPipe Hand Tracking을 활용해 손 랜드마크와 검지 끝 좌표를 실시간으로 추출했습니다. - 객체 이해 (Object Understanding)

시야 안의 물체를 인식하고, 어떤 객체에 주의를 기울이는지 판단합니다.

→ 이번 데모에서는 YOLO 기반 객체 탐지를 활용하여 마우스·컵·키보드 등을 실시간으로 인식했습니다. - 환경 이해 (Environment Understanding)

SLAM 등의 기술을 사용해 주변 공간 구조나 내 위치를 파악하는 영역입니다.

→ 이번 데모에서는 공간 추적 기능은 적용하지 않았지만, 향후 객체 위치 기반 인터랙션 확장에 활용할 수 있는 영역입니다. - 통합적 이해 (Hybrid Understanding)

주체·객체·환경 정보를 통합해 상황을 요약하거나 행동을 예측합니다.

→ 이번 데모는 “손의 상태(열림/닫힘) + 객체의 위치 + 손끝 좌표”를 통합하여

현재 손에 어떤 물체를 들고 있는지 판단하는 로직을 구현했습니다.

요약하면

이번 “What’s in my hand?” 데모는 에고센트릭 비전 기술 중에서도 주체 이해(손 추적) + 객체 이해(실시간 물체 인식) + 통합적 이해(거리 계산 기반 판단)

세 가지 핵심 요소를 결합하여 동작합니다.

즉, 내가 보고·집은 물체를 AI가 즉시 이해하고 음성으로 알려주는 에고센트릭 인터랙션의 기본 구조를 구현한 사례입니다.

[에고센트릭 비전 주요 과제 분류표]

| 분류 | 설명 | 하위 과제 예시 |

| 주체 이해 (Subject Understanding) | 사용자의 행동, 의도, 장면과의 상호작용 분석 | – 시선이해- 자세추정- 행동 인식 및 예측- 행동 관련 소리인지 |

| 객체 이해 (Object Understanding) | 사용자의 주의가 향하는 외부 객체 분석 | – 사회적 인지- 개체 객체 인지- 인간 개체 인식- 궤적 예측 |

| 환경 이해 (Environment Understanding) | 장면 구조 및 공간 구성 이해 | – 동시적 위치추적 및 지도작성 – 장면 위치추정 – 시각적 장소 인식- 카메라 위치추정 |

| 통합적 이해(Hybrid Understanding) | 주체, 객체, 환경 정보를 통합하여 복합 장면 이해 | – 내용 요약- 다중 시점 통합- 비디오 질의응답 |

2). 활용 분야

이 기술은 산업 안전부터 일상 편의까지 광범위하게 적용됩니다.

예를 들어 작업자의 시선에서 위험 요소를 탐지하는 스마트 헬멧, 시각장애인을 위한 보행 보조 도구, 그리고 EPIC-KITCHENS 데이터셋 사례처럼 요리 과정을 단계별로 안내하는 서비스 등이 있습니다.

[분야별 활용 예시 및 EPIC-KITCHENS 데이터 소개]

| 분야 | 활용 예 |

|---|---|

| 산업 안전 | 스마트헬멧 → 작업자의 시선에 위험요소 탐지 |

| 헬스케어 | 시각장애인 보조 → 사물 인식·음성 안내 |

| AR 인터페이스 | 스마트 글래스에서 실시간 물체 및 사람 인식 |

| 로보틱스 | 로봇의 시야 내 행동 예측 및 경로 계획 |

| 게임/VR | 유저 시선 기반 상호작용 및 맞춤 콘텐 |

| 요리 지원(EPIC-KITCHENS) | 사용자 숙련도에 따라 단계별 안내 제공 |

2. 엣지 컴퓨팅: 0.1초의 반응 속도를 위하여

AI가 상황을 이해하는 것만으로는 충분하지 않습니다. 사용자의 행동에 즉각적으로 반응할 수 있는 속도, 즉 실시간성이 핵심입니다. 그러나 클라우드 기반 처리 방식은 네트워크 왕복 지연이 발생할 수밖에 없으며, 이는 인터랙티브 비전 AI의 품질을 크게 떨어뜨립니다. 이 문제를 해결하는 기술이 바로 엣지 컴퓨팅(Edge Computing)입니다.

1). 왜 엣지인가? (Cloud vs. Edge)

엣지 컴퓨팅은 데이터를 중앙 서버로 전송하지 않고, 데이터가 생성되는 디바이스 근처에서 즉시 처리합니다. 이 접근 방식은 실시간 AI 서비스에서 다음과 같은 명확한 이점을 제공합니다.

- 초저지연(Low Latency)

네트워크 왕복 시간이 사라져 0.1초 단위 반응성 구현 가능 - 보안 강화(Security)

영상 프레임이 외부로 전송되지 않아

민감 정보 유출 위험을 원천 차단 - 비용 절감(Cost Efficiency)

대용량 영상 스트리밍 비용과 클라우드 GPU 사용료 감소

제조업의 예지 보전(Predictive Maintenance), 자율주행차의 판단 로직, AR·VR 장비의 실시간 상호작용처럼 찰나의 반응이 중요한 분야에서 엣지 컴퓨팅은 필수 기술로 자리잡고 있습니다.

이번 데모 역시 개인 노트북에서 모든 AI 추론을 로컬로 처리해, 이러한 엣지 컴퓨팅의 장점을 그대로 활용했습니다.

[클라우드 vs 엣지 비교표]

| 항목 | 클라우드 | 엣지 |

| 처리 위치 | 중앙 서버(데이터 센터) | 디바이스근처 (IoT, 스마트폰, 공장 등) |

| 응답 속도 | 비교적 느림(네트워크 왕복) | 빠름(로컬 실시간 처리) |

| 네트워크 의존도 | 높음 | 낮음 |

| 개인정보 위험 | 높음 | 낮음(로컬 처리로 유출 최소화) |

3. 프로젝트 구현: “What’s in my hand?”

앞서 설명한 이론적 배경을 바탕으로, 저는 웹캠 영상을 입력으로 받아 사용자가 손에 쥐고 있는 물체를 실시간으로 인식하고 음성으로 안내하는 시스템을 엣지 환경에서 구현했습니다.

1). 시스템 아키텍처

전체 시스템의 데이터 흐름은 다음과 같이 구성됩니다.

먼저, Camera Frame에서 실시간으로 캡처된 영상 프레임을 받아 두 개의 경로로 병렬 처리합니다.

- HandDetector : MediaPipe를 사용하여 손의 위치와 제스처(Open / Closed)를 판별하고, 검지 끝 좌표를 추출합니다.

- ObjectDetector : YOLO 기반 객체 인식 모델이 프레임 내의 컵·키보드·마우스 등 주변 물체를 실시간으로 탐지합니다.

이후 MainApplication 모듈이 두 인식 결과를 통합해 판단을 수행합니다.

손이 ‘쥠(Closed)’ 상태이고, 손끝 좌표와 가장 가까운 객체가 존재한다면 현재 손에 들고 있는 물체로 판단합니다. 판단된 객체는 TTSManager를 통해 음성으로 즉시 안내됩니다.

이 모든 처리는 로컬 디바이스 내부에서 완전히 수행되기 때문에, 네트워크 지연 없이 매끄러운 실시간 인터랙션이 가능합니다.

아래 표에는 시스템을 기능별로 모듈화하여 구성한 내용을 정리했습니다.

모델 교체나 파라미터 튜닝은 각 모듈의 설정을 관리하는 config 파일에서만 수정하면 되도록 설계하여, 기능 확장과 유지보수가 용이합니다.

[시스템 구성도]

[모듈별 기능 정리 표]

| 모듈명 | 주요 기능 요약 |

| main_application.py | – 전체 앱 실행 및 프레임 처리- 각 모듈 호출- 화면 출력 및 종료 관리 |

| hand_detector.py | – MediaPipe로 손 인식- 손 제스처 판단 (Open/Closed)- 검지 손끝 좌표 추출출 |

| object_detector.py | – YOLOv8으로 객체 감지- 거리 계산으로 가장 가까운 객체 추정 |

| tts_manager.py | – 잡고 있는 객체 이름을 음성으로 안내(pyttsx3) |

| config.py | – 모델 경로, TTS 속도, 인식 임계값 등 공통 설정값 정의 |

2). 개발 환경 및 라이브러리 (Tech Stack)

실시간 처리를 위해 경량화된 모델(YOLOv8n)을 선택하고, 로컬 노트북의 RTX 4060 Ti GPU를 활용해 추론 속도를 확보했습니다. 아래는 본 프로젝트에서 사용한 주요 라이브러리 및 프레임워크 구성과 엣지 디바이스 환경입니다.

[라이브러리 및 프레임워크 구성 표]

| 범주 | 라이브러리/프레임워크 | 설명 |

| 객체 탐지 | Ultralytics==8.x(YOLOv8) | 사전학습된 YOLOv8n 모델 사용 |

| 손 추척 및 자제 추정 | MediaPipe | Hand tracking 및 랜드마크 추출 |

| 음성 출력 | pyttsx3 | 오프라인 TTS |

| 영상 처리 | OpenCV | 영상 스트림 캡처, 출력, 그리기 |

| 산식 계산 | math | 유클리디안 거리 계산 등 |

[Edge device 환경 – 개인 노트북]

| 항목 | 내용 |

| 개발 OS | Window11 |

| GPU | RTX 4060 Ti Laptop GPU (CUDA 사용 가능) |

| Python 환경 | Anaconda 가상환경 기반, python3.11 |

| 실행 환경 | main_application.py 실행 (카메라 기반) |

| 입력 장치 | Laptop Webcam (cv2.VideoCapture(0)) |

| 출력 방식 | OpenCV 창 + pyttsx3 음성 출력 |

| 기타 설정 | TTS_RATE=160, SPEAK_DELAY=30, YOLO_CONFIDENCE=0.7 |

- Object Detection: Ultralytics YOLOv8n(Nano 버전)을 사용하여 실시간성 보장에 집중했습니다.

- Pose Estimation: MediaPipe를 활용해 별도의 무거운 모델 없이도 손가락 관절(Landmark)을 정밀하게 추적했습니다.

- Hardware: Windows 11 기반의 노트북에서 RTX 4060 Ti (8GB VRAM)를 활용해 CUDA 가속을 적용했습니다.

4. 핵심 로직: ‘잡았다’는 판단의 기준

단순히 손과 컵이 화면에 같이 있다고 해서 ‘잡았다’고 볼 수는 없습니다. 저는 두 가지 조건을 결합하여 트리거 로직을 적용하였습니다.

- 제스처 상태 (State): MediaPipe 랜드마크 분석 결과, 손가락이 오므려진 ‘Closed’ 상태여야 한다.

- 근접 거리 (Distance): 손의 검지 끝 좌표와 객체의 중심 좌표 간의 유클리디안 거리(Euclidean Distance)가 임계값 이내여야 한다.

Python

# 핵심 로직 의사코드 (Pseudo-code)

finger_tip = hand_landmarks[8] # 검지 끝

obj_center = object_box.center

distance = calculate_distance(finger_tip, obj_center)

if (hand_gesture == “Closed”) and (distance < THRESHOLD):

tts.speak(f”You are holding a {object_name}”)

5. 데모 시연 결과

이번 영상은 제가 구현한 에고센트릭 비전 기반 실시간 인터페이스 데모 “What’s in my hand?” 의 실제 동작 모습을 담고 있습니다. 웹캠으로 촬영된 사용자의 시야를 기반으로, AI가 손의 상태와 주변 객체를 실시간으로 해석해 어떤 물체를 집고 있는지를 즉시 판단하는 방식입니다.

먼저, 화면 하단에서는 YOLO 모델이 마우스·키보드·컵 등 주변 물체를 실시간으로 탐지하며, 각 객체는 신뢰도(Confidence Score)와 함께 바운딩 박스로 표시됩니다. 화면 오른쪽에는 MediaPipe Hand Tracking을 통해 추적된 손 랜드마크가 나타나고, 특히 검지 끝점은 굵은 원형 마커로 강조하여 객체와의 관계를 직관적으로 확인할 수 있습니다. 화면 왼쪽 상단에서는 손의 제스처(Open / Closed)가 실시간으로 업데이트되어 현재 손의 상태를 한눈에 파악할 수 있습니다.

핵심 로직은 손끝 좌표와 객체 중심 좌표 간의 유클리디안 거리(Euclidean Distance) 계산입니다. 손이 ‘닫힌(Closed)’ 상태일 때 이 거리 데이터를 바탕으로 주변 객체 중 어떤 물체를 실제로 쥐고 있는지 판단하고, 인식된 결과는 TTS(Text-to-Speech)로 즉시 음성 안내됩니다.

특징적인 점은 이 모든 과정이 클라우드를 거치지 않고 100% 로컬에서 실행된다는 것입니다. 웹캠 입력부터 객체 탐지, 손 추적, 거리 계산, 음성 출력까지 모두 노트북 내부에서 처리되기 때문에 네트워크 지연이 전혀 없이 자연스러운 실시간 인터랙션을 구현할 수 있었습니다.

[데모 시연 화면 – https://youtu.be/vhLGr_k8DIM ]

6. 마치며

이번 프로젝트는 에고센트릭 비전 기술을 엣지 디바이스에 적용하여, “AI가 인간의 행동을 이해하고 즉시 반응하는 경험”을 구현해 보았다는 데에 의의가 있습니다.

단순한 데모였지만, 이 구조는 공공기관과 제조업의 DX 환경에서 충분히 실용적인 형태로 확장할 수 있습니다. 예를 들어, 작업자의 손 동작과 주변 장비를 자동으로 인식해 위험 행동을 사전에 감지하는 안전 모니터링 시스템, 매뉴얼 없이도 작업자의 시야 안에서 필요한 정보를 바로 안내하는 현장 작업 가이드, 점검·정비 시 필요한 장비나 부품을 자동 인식해 오류 방지·작업 효율 향상을 지원하는 솔루션 등으로 발전시킬 수 있습니다.

또한 공공 분야에서는 민원 현장의 업무 절차 안내, 시설 점검 자동화, 재난 대응 상황에서의 현장 인식 등에도 적용 가능해 1인칭 시점 기반의 디지털 행정 서비스로 확장할 여지가 있습니다.

앞으로 에고센트릭 데이터(Egocentric Data)가 축적될수록, AI가 사용자의 행동·의도·맥락을 더 정확하게 이해하게 되고, 현장의 DX는 한층 더 세밀해질 것입니다.긴 글 읽어주셔서 감사합니다.

질문이나 피드백은 언제든 환영합니다!